”Spark “ 的搜索结果

Spark是基于内存计算的大数据并行计算框架,实际中运行计算任务肯定是使用集群模式,那么我们先来学习Spark自带的standalone集群模式了解一下它的架构及运行机制。 Standalone集群使用了分布式计算中的master-slave...

Apache Spark开源生态系统在2014上半年大幅增长,已迅速成为大数据领域中...伴随着Spark平台的发展,Spark Summit2014于6月30日在旧金山正式展开为期三天的峰会,也是有史以来最大的Spark会议。Mate Zaharia在加州大

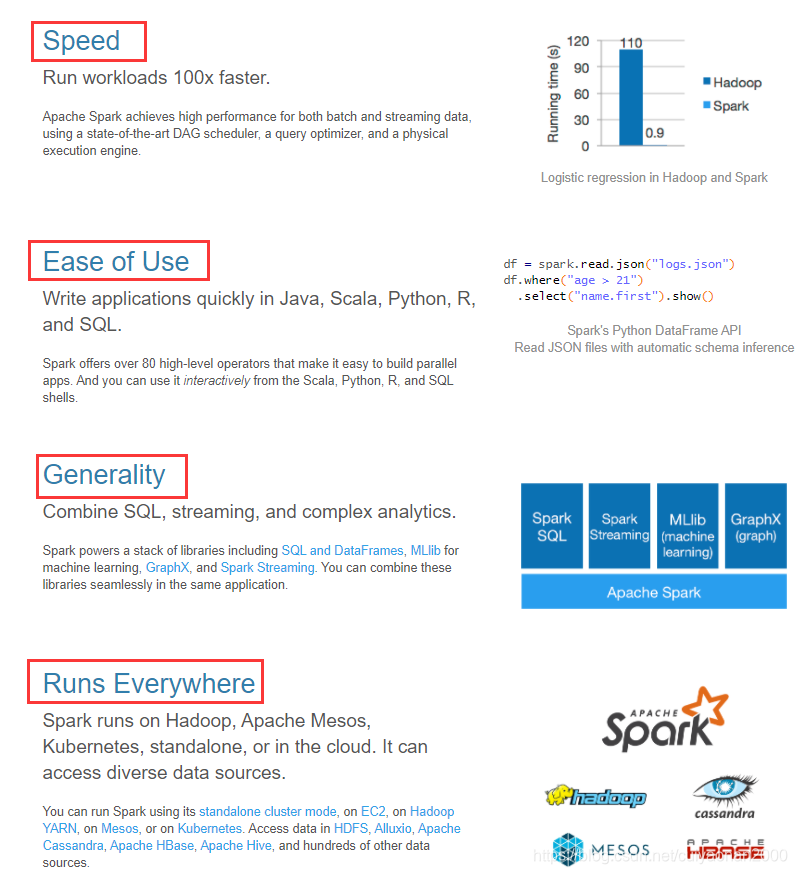

Spark是大数据的调度,监控和分配引擎。它是一个快速通用的集群计算平台.Spark扩展了流行的MapReduce模型.Spark提供的主要功能之一就是能够在内存中运行计算 ,但对于在磁盘上运行的复杂应用程序,系统也比MapReduce...

参考文章:使用springboot构建rest api远程提交spark任务 github代码链接:github地址 1. spark集群及版本信息 服务器版本:centos7 hadoop版本:2.8.3 spark版本:2.3.3 使用springboot构建rest api远程提交spark...

1.DataFrameReader是什么? 目标 理解DataFrameReader的整体结构和组成 SparkSQL的一个非常重要的目标就是完善数据读取, 所以SparkSQL中增加了一个新的框架, 专门用于读取外部数据...val spark: SparkSession...

Spark 读 S3 Parquet 写入 Hudi 表 目录 Spark 读 S3 Parquet 写入 Hudi 表 参考 关于S3,S3N和S3A的区别与联系 Spark 读写 S3 Parquet 文件 测试代码 pom.xml 配置文件 EMR Spark任务提交 spark-...

Spark是一种基于内存的、用以实现高效集群计算的平台。Spark有着自己的生态系统,但同时兼容HDFS、Hive等分布式存储系统,可以完美融入Hadoop的生态圈中,代替MapReduce去执行更高的分布式计算。

第1关:数据清洗--过滤字段长度不足...importorg.apache.spark.sql.{DataFrame,Dataset,SparkSession} objectedu{ /**********Begin**********/ //此处可填写相关代码 caseclassPerson(id:String,Name:String,...

pyspark 从已有数据表读取数据写入目标hive表的代码模板

Spark-3.2.4 高可用集群安装部署详细图文教程

和一个文件格式不同,Hive是一个外部的数据存储和查询引擎, 所以如果Spark要访问Hive的话, 就需要先整合Hive 整合什么 ? 如果要讨论SparkSQL如何和Hive进行整合, 首要考虑的事应该是Hive有什么, 有什么就整合什么就...

Spark SQL下的Parquet使用最佳实践和代码实战 分类: spark-sql(1) 一、Spark SQL下的Parquet使用最佳实践 1)过去整个业界对大数据的分析的技术栈的Pipeline一般分为以下两种方式: ...

IDEA编写Spark程序

标签: spark

目录 pom.xml 本地运行 集群运行 Java8版 pom.xml ●创建Maven项目并补全目录、配置pom.xml <?xml version="1.0" encoding="UTF-8"?> <project xmlns=... ...

我们之前学习过hive,hive是一个基于hadoop的SQL引擎工具,目的是为了简化mapreduce的开发。由于mapreduce开发效率不高,且学习较为困难,为了提高mapreduce的开发效率,出现了hive,用SQL的方式来简化mapreduce:...

自行查看

一、你是怎么理解Spark,它的特点是什么?Spark是一个基于内存的,用于大规模数据处理(离线计算、实时计算、快速查询(交互式查询))的统一分析引擎。...

推荐文章

- 『Android 技能篇』优雅的转场动画之 Transition-程序员宅基地

- Webshell绕过技巧分析之-base64编码和压缩编码-程序员宅基地

- 大一计算机思维知识点,大学计算机—基于计算思维知识点详解.docx-程序员宅基地

- 关于敏捷开发的一篇访谈录-程序员宅基地

- 挑战安卓和iOS!刚刚,华为官宣鸿蒙手机版,P40搭载演示曝光!高管现场表态:我们准备好了...-程序员宅基地

- 精选了20个Python实战项目(附源码),拿走就用!-程序员宅基地

- android在线图标生成工具,图标在线生成工具Android Asset Studio的使用-程序员宅基地

- android 无限轮播的广告位_轮播广告位-程序员宅基地

- echart省会流向图(物流运输、地图)_java+echart地图+物流跟踪-程序员宅基地

- Ceph源码解析:读写流程_ceph 发送数据到其他副本的源码-程序员宅基地